本文最后更新于:2023年2月28日 下午

方差分析是研究分类型自变量与数值型因变量之间关系的统计方法

相关(度量变量之间的关系强度)与回归(探究变量之间的数据伴随关系)分析是研究数值型变量之间关系的统计方法

- 两个变量:简单相关与简单回归分析

- 多个变量:多元相关与多元回归分析

1. 变量间关系

按关系形态,变量间关系可分为:

- 函数关系:因变量完全依赖于自变量

- 相关关系:变量之前存在不确定数量关系

相关关系的度量

相关系数 (correlation coefficient)

根据样本数据计算的对两个变量之间线性关系强度的度量值.总体相关系数记为 ρ,样本相关系数记为 r。

2. 一元线性回归

一元线性回归模型

模型建立

因变量 (dependent variable)

回归分析中,被预测或被解释的变量,记为 y

自变量 (independent variable)

回归分析中,用来预测或解释的一个或多个变量,记为 x

回归模型 (regression model)

描述因变量 y 如何依赖于自变量 x 和误差项 ϵ 的方程

如一元线性回归模型:

y=β0+β1x+ϵ

-

β0+β1x :反映由 x 变化引起的 y 的线性变化,β0,β1 是模型的参数(常数)

-

ϵ :误差项的随机变量,反映除x 变化引起的 y 的线性变化之外随机因素对 y 的影响,满足 ϵ∼N(0,σ2)

回归方程 (regression equation)

描述因变量 y 的期望值如何依赖于自变量 x 的方程

如一元线性回归方程(直线回归方程):

E(y)=β0+β1x

估计的回归方程 (estimated regression equation)

利用最小二乘法,根据样本数据求出回归方程的估计

如一元线性的估计的回归方程:

y^=β0^+β1^x

- β0^:回归直线在 y 轴上的截距的估计

- β1^:回归直线斜率的估计

- y^:y 的估计

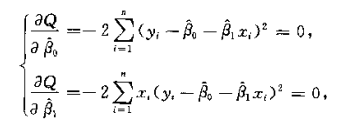

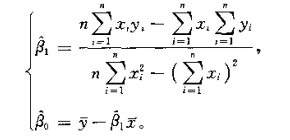

参数的最小二乘估计 (method of least squares)

最小二乘法是使因变量的观测值 yi 与估计值 yi^ 之间的离差平均和最小求得 β0^,β1^

最小二乘法的目标函数:

min∑(yi−yi^)2=min∑(yi−β0^−β1^xi)2

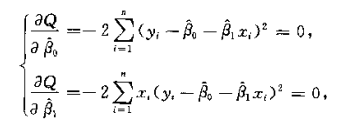

根据极值定理可得关于参数 β0,β1 偏导数的等式:

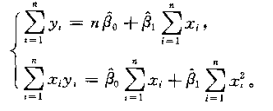

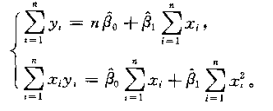

化简得到参数 β0,β1的标准方程组:

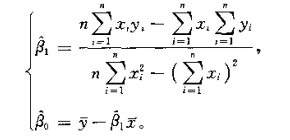

解标准方程组得到参数 β0,β1的表达式:

模型评估

回归直线对数据的拟合优度 (goodness of fit)

回归直线与各观测点的接近程度,通过判定系数度量

判定系数 (coefficient of determination)

回归平方和占总平方和的比例,记为 R2

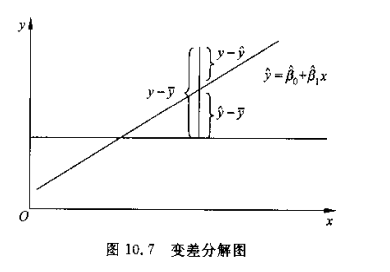

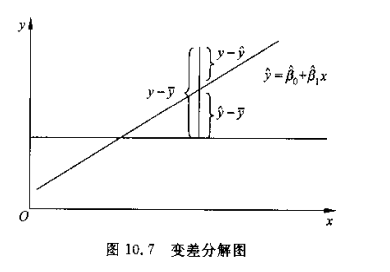

总平方和、回归平方和、残差平方和

-

反映因变量 y 取值的波动(变差):观测值 yi 与均值 y 的离差平方和,总平方和 SST

SST=∑(yi−y)2

-

反映自变量 x 与因变量 y 之间的线性关系造成的波动:预测值 yi^ 与均值 y 的离差平方和,回归平方和 SSR

SSR=∑(yi^−y)2

-

反映线性关系外其他因素造成的波动:观测值 yi 与预测值 yi^ 的离差平方和,残差平方和 SSE

SSE=∑(yi−yi^)2

-

平方和间关系

SST=SSR+SSE

判定系数 R2

R2=SSTSSR=∑(yi−y)2∑(yi^−y)2

可化为关于 xi,yi,x,y, 的关系式

R2=[∑(xi−x)2∑(yi−y)2∑(xi−x)(yi−y)]2

相关系数 r

判定系数的平方根,与回归系数 β1^ 符号相同

r=∑(xi−x)2∑(yi−y)2∑(xi−x)(yi−y)

- ∣r∣ 越接近 1,拟合程度越高

- r 不能直接说明拟合优度,如 r=0.5 时,R2=0.025,回归平方和只能解释总变差的 25%,而非 50%

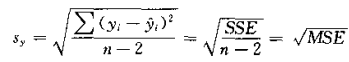

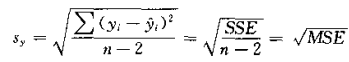

估计量的标准差/标准误差 (standard error of estimate)

均方残差的平方根 (MSE),反映了用估计的回归

方程预测因变量 y 时预测误差的大小,记作 sy

- sy 越小,回归直线对各观测点的代表性就越好,

- 由于估计的回归方差由最小二乘法得到,其目标就是使 ∑(yi−yi^)2 最小,因此回归直线是估计标准误差最小的直线

显著性检验

检验模型方程是否真实反映了自变量 x 和因变量 y 间的关系,主要包括:

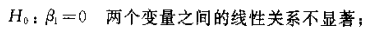

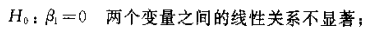

线性关系的检验

检验自变量 x 和因变量 y 间的线性关系是否显著,能否用线性模型表示

-

提出假设

-

计算检验统计量 F

F=MSEMSR=n−2SSE1SSR∼F(1,n−2)

当线性回归的自变量个数为 p 时:

- SSR 自由度为 p,一元线性回归中为 1

- SSE 自由度为 n−p−1,一元线性回归中为 n−2

-

决策

查 F 分布表得到 df=(1,n−2) 处的临界值 Fα

- F>Fα,拒绝 H0

- F<Fα,不拒绝 H0

模型预测